BentoML 文档¶

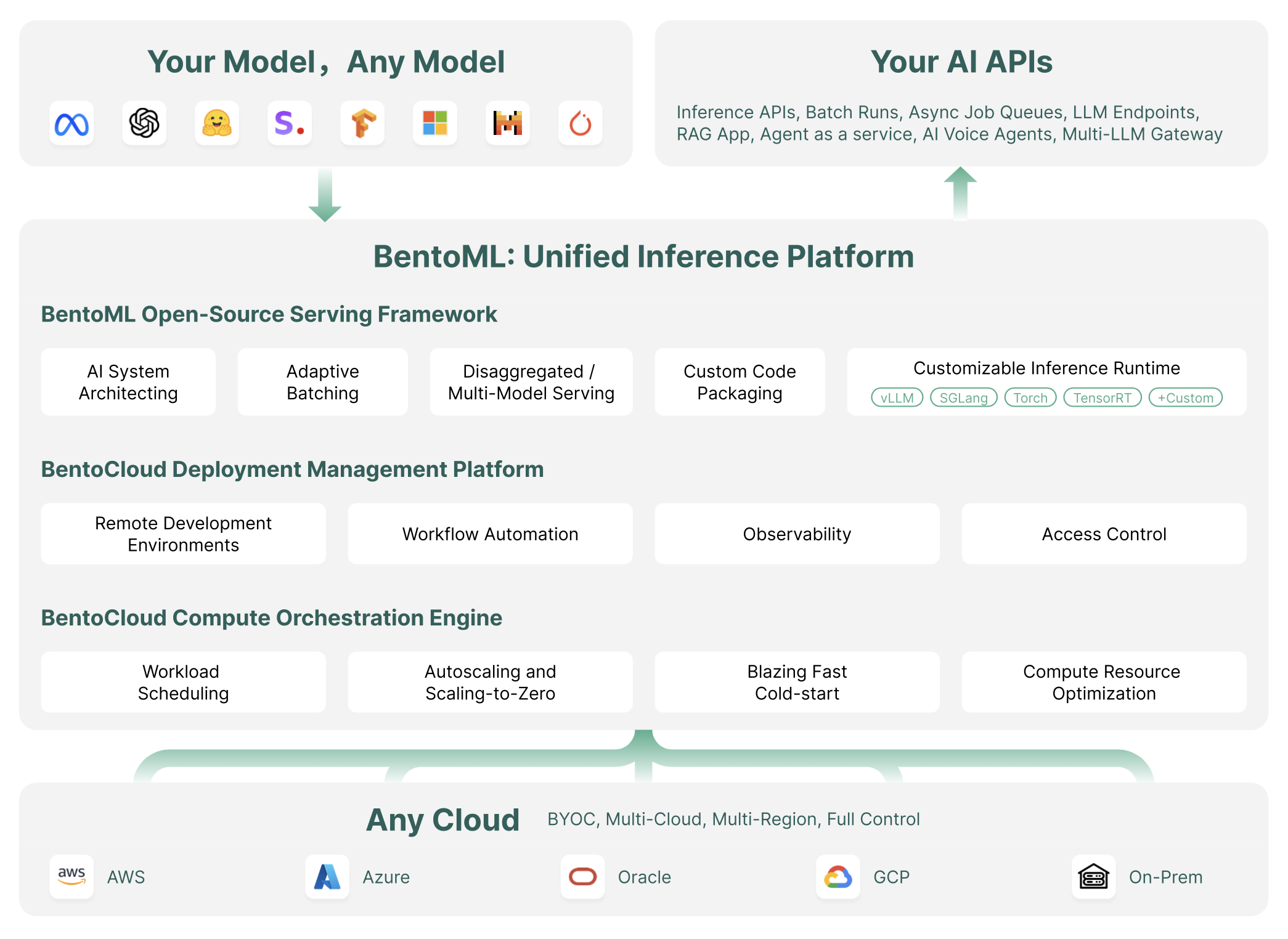

BentoML 是一个统一推理平台,用于在任何云上使用任何模型部署和扩展 AI 系统。

精选示例¶

使用兼容 OpenAI 的 API 和 vLLM 推理后端服务大型语言模型。

使用开源嵌入模型和大型语言模型部署私有 RAG 系统。

部署具有灵活定制和优化批处理功能的图像生成 API。

使用 ComfyUI 流水线通过队列执行自动化可重现的工作流。

使用开源模型和 Twilio 构建具有端到端流式处理能力的电话呼叫 Agent。

使用 Google 的安全内容审核模型保护您的 LLM API 端点免受有害输入的侵害。

探索开发者如何使用 BentoML 构建应用。

什么是 BentoML¶

BentoML 是一个统一推理平台,用于以生产级可靠性部署和扩展 AI 模型,无需复杂的管理基础设施。它使您的开发者能够使用自定义模型将 AI 系统的构建速度提高 10 倍,在您的云中高效扩展,并保持对安全性和合规性的完全控制。

BentoML 入门

使用 pip 安装 BentoML 开源模型服务框架,它作为 Python 包发布在 PyPI 上。

# Recommend Python 3.9+ pip install bentoml

注册 BentoCloud 获取免费试用。

操作指南¶

使用 BentoML 构建您的自定义 AI API。

通过一条命令将您的 AI 应用程序部署到生产环境。

配置快速自动扩展以实现最佳性能。

使用 BentoML 在 GPU 上运行模型推理。

使用您喜爱的 IDE 通过强大的云 GPU 进行开发。

使用 BentoML 加载和提供您的自定义模型。

保持关注¶

BentoML 团队通过以下渠道发布重要更新,例如主要产品版本发布,并分享教程、案例研究以及社区新闻。

要接收版本发布通知,请在 GitHub 上 Star 并 Watch BentoML 项目。有关版本说明和详细更改日志,请参阅版本发布页面。